In questi ultimi anni i dati disponibili sono cresciuti ad un ritmo esponenziale. Ormai è un assunto condiviso che l’attività quotidiana di ciascuno di noi sia tramite l’attività lavorativa, sia tramite la gestione del tempo libero genera dati e questo è vero anche per le aziende, gli impianti, addirittura macchine ed elettrodomestici.

La diffusione di mezzi tecnologici sempre più performanti e disponibili al consumo di massa, in una realtà che ci vede sempre interconnessi nel mondo 24 ore su 24, ha contribuito al diffondersi dei social generando l’esplosione di contenuti condivisi tra i diversi utenti di tutto il mondo. Esistono sensori che acquisiscono a ciclo continuo dati metereologici o informazioni sulla nostra macchina, ogni giorno vengono archiviate registrazioni che si accumulano nei database bancari, assicurativi e telefonici, impianti di sicurezza e tutor autostradali rilevando ed archiviano immagini e video, ci scambiamo anche senza saperlo segnali Gps.

I dati sono ovunque. Allora, che cosa fa la differenza?

L’esistenza ridondante di dati non dà nessun valore aggiunto se non si è in grado di interpretarli, gestendoli, pulendoli e soprattutto sapendo cosa cercare, una volta riconosciuti dei pattern cognitivi nell’intercettazione degli schemi di dati, la capacità di calcolo degli algoritmi, nell’intercettazione di schemi nei dati, è sicuramente superiore a quella umana riuscendo a generare vantaggi competitivi se l’analisi e crematura dei dati è stata svolta in maniera efficace.

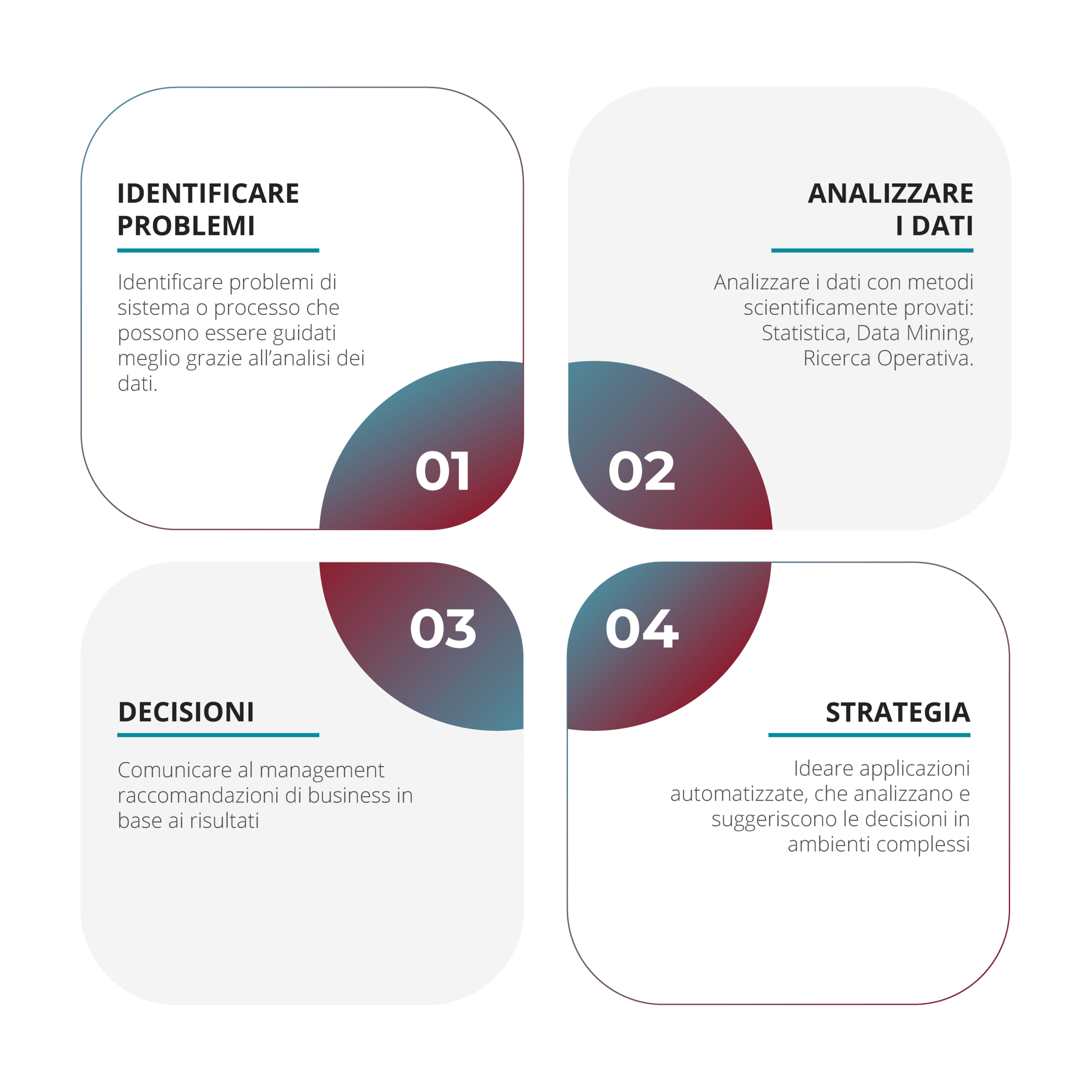

Diventa chiaro che prima di qualsiasi scelta è importante pensare strategicamente agli obiettivi che ci vogliamo porre, viceversa potremmo gestire le nostre risorse in maniera inefficace, ingigantendo costi e intercettando correlazioni non “razionali” frutto del “rumore” generato dalla massa dei dati analizzati. I progetti di successo saranno comunque i progetti dotati di una pianificazione mirata e costruita ad hoc per le specifiche esigenze aziendali, così da concentrare gli sforzi e massimizzare tempo e risorse, e coinvolgendo le persone e competenze giuste necessarie per la realizzazione del progetto.

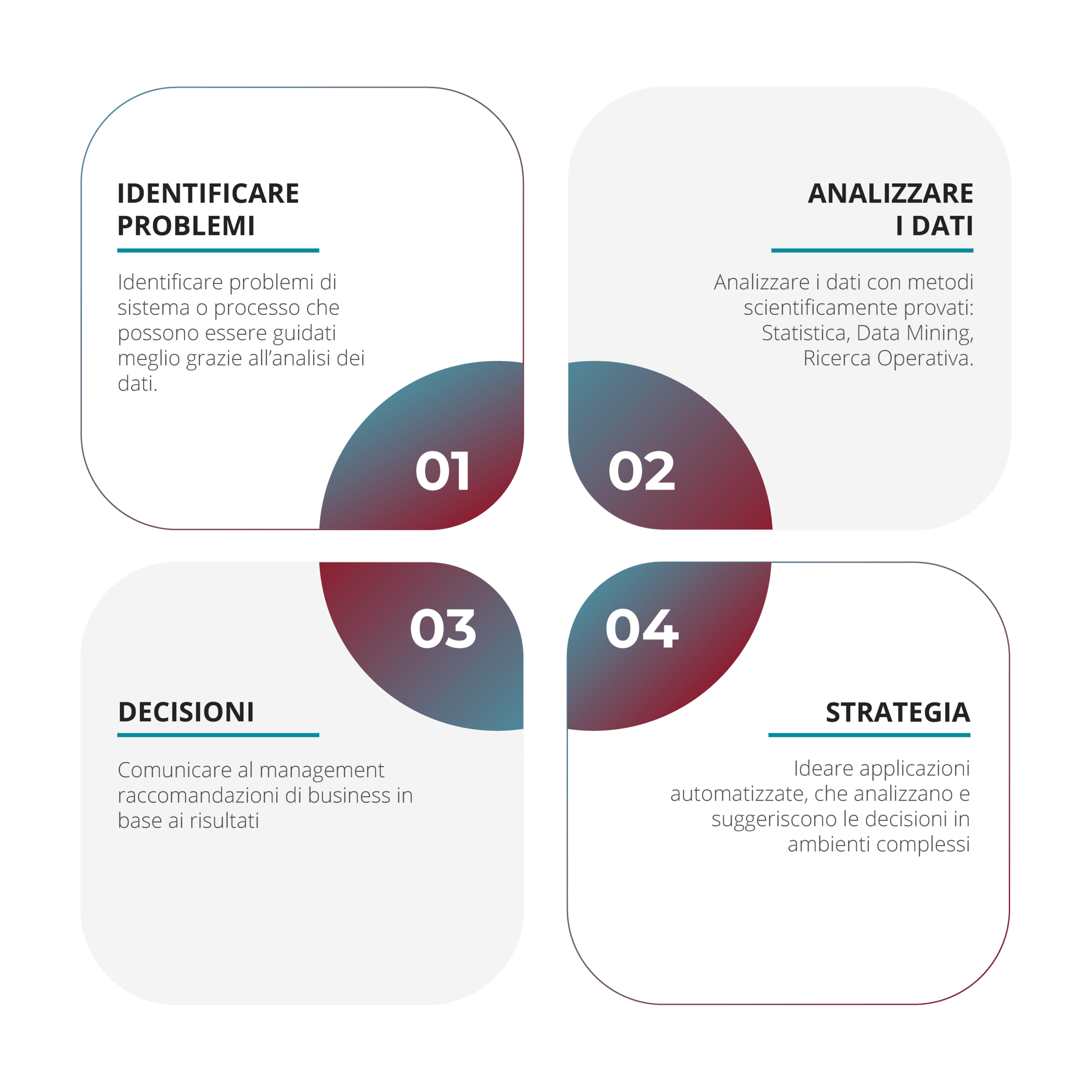

I principali impieghi della data analysis in azienda

.

.

La figura del Data Scientist

L’acquisizione del dato, la sua pulizia e manipolazione necessitano di esperienza e competenza maturata in ambienti e settori trasversali e multidisciplinari non unicamente informatici, sfruttando competenze e nozioni matematiche e statistiche.

L’insieme di queste competenze e caratteristiche ha concorso a determinare una nuova figura professionale comunemente nota con il termine “Data Scientist”, figura in grado di dare un senso ai Big Data estrapolando pattern e indicazioni utili al processo decisionale, per rimanere al passo con la competitività del business garantendo importanti vantaggi competitivi rispetto al mercato di riferimento.

In realtà analizzare ed interpretare dati non è un nuovo mestiere, in quanto l’analisi dei dati è nota come statistica. Tuttavia negli ultimi quarant’anni, e con l’accelerazione dell’ultimo decennio, è avvenuta una mutazione del contesto, che costringe a ridefinire ruoli e professioni. Fino ai primi anni ‘90, gli analisti di dati dovevano porsi il problema di quali dati raccogliere, quali interviste commissionare, come codificarle e renderle disponibili per un software che le analizzasse con l’obiettivo di trarre conoscenza e previsioni utilizzando il minor numero di dati possibili. Dagli anni ’90 in poi, con la prima ondata di Internet e del commercio elettronico in particolare, la situazione si è profondamente modificata, con molte informazioni già disponibili in formati digitali strutturati o non strutturati; tale abbondanza di dati ha ribaltato il tradizionale paradigma di analisi statistico, aprendo spazio alla Computer Science, molto più vicina al reale svolgimento dei fatti, con metodi e algoritmi adatti a indagare dati in quantità assolutamente inusuale per gli statistici, generando nuove discipline note come Data Mining e Machine Learning.

La capacità di analisi ed interpretazione del Data Scientist lo pone come una figura professionale centrale e richiesta nel mondo aziendale grazie alla capacità di generare vantaggi competitivi dai dati aziendali memorizzati, ma non analizzati.

A titolo di esempio possiamo considerare il caso dei dati prodotti dalla sensoristica delle automobili. Questi ultimi in massima parte sono analizzati solo dopo il guasto segnalato dall’apparecchiatura di diagnostica del meccanico o in occasione di manutenzioni programmate; un’analisi dei dati basata viceversa su un approccio di Machine Learning con l’applicazione di algoritmi customizzati per l’applicazione di manutenzione predittiva per tutte le auto dello stesso modello, porterebbe enormi benefici economici, di sicurezza ed affidabilità dei mezzi.

La versatilità delle competenze delle attività di analisi e consulenza svolte dal Data Scientist a supporto del business aziendale consente di adattarsi a seconda delle esigenze aziendali.

Le principali competenze del Data Scientist in azienda

Quali aziende stanno investendo maggiormente

A partire dalla seconda metà del decennio 2010 gli investimenti nel campo dei Big Data ammontavano globalmente ad una cifra che si aggirava ai 170 milioni di euro, mentre gli investimenti nella “tradizionale” Business Intelligence superavano i 700 milioni di euro.

Da allora la crescita è proceduta ad un ritmo esponenziale fino a raggiungere gli attuali 1,7 miliardi di euro con un tasso di crescita medio annuo del +21,3%.

I principali investitori in questo settore sono aziende di grandi dimensioni: si calcola infatti che il 93% delle imprese di grandi dimensioni investa in progetti di Bi Data Analytics, contro una quota del 62% delle aziende di piccola e media dimensione.

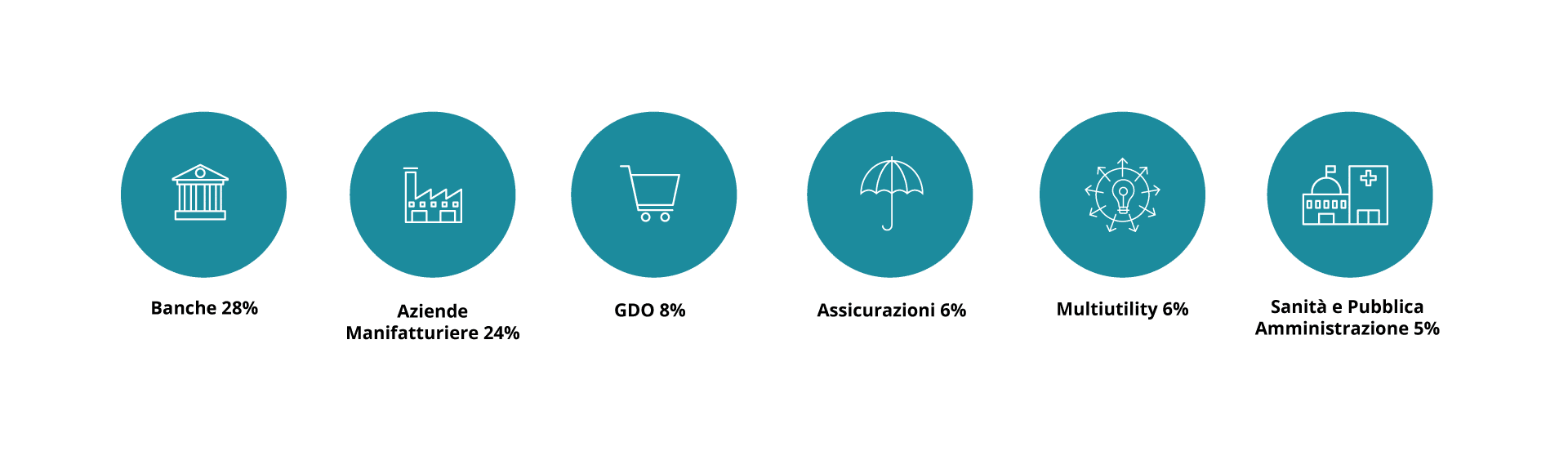

Interessante è notare il graduale e diversificato approccio in questa tipologia di investimenti a seconda del settore di Business di appartenenza.

Le prime aziende ad interessarsi alla tematica sono state le aziende di telecomunicazione, seguite a ruota dalle Multiutility, dalle aziende Finance, dalle Assicurazioni, dalla GDO, dalle aziende farmaceutiche e manufatturiere.

Il valore aggiunto e competitivo generato dall’analisi massiva dei dati tramite algoritmi sempre più sofisticati ed infrastrutture di calcolo e stoccaggio di dati sempre più potenti e accessibili economicamente ha veicolato sempre di più l’interesse dei diversi player aziendali all’implementazione di tali approcci nel proprio business con sviluppi sempre più accelerati.

Una fotografia attuale dei settori di investimento vede le banche al primo posto con quote di mercato pari al 28% della spesa, seguite dal manifatturiero con una quota pari al 24%, GDO 8%, servizi assicurativi 6%, Multiutility 6% ed infine Imprese sanitarie e Pubblica Amministrazione con una quota del 5%.

L’analisi delle principali voci spesa negli investimenti in Big Data evidenzia come la quota maggiore sia costituita da software, con una quota degli strumenti per la visualizzazione ed analisi dei dati pari al 53% e la restante parte costituita da strumenti di “ingestion” dei dati, integrazione, preparazione e governance.

Una quota pari al 33% degli investimenti complessivi è rivolta a strumenti di personalizzazione dei software, all’integrazione con i sistemi aziendali e a servizi di consulenza per la progettazione dei processi.

Una quota pari al 20% degli investimenti è dedicata a risorse infrastrutturali per fornire capacità di calcolo ed immagazzinamento dei dati, con una quota sempre maggiore occupata dal Cloud.

La crescita dell’IoT e dei dispositivi connessi aumenta la quantità di dati.

Come costruire una data strategy efficace?

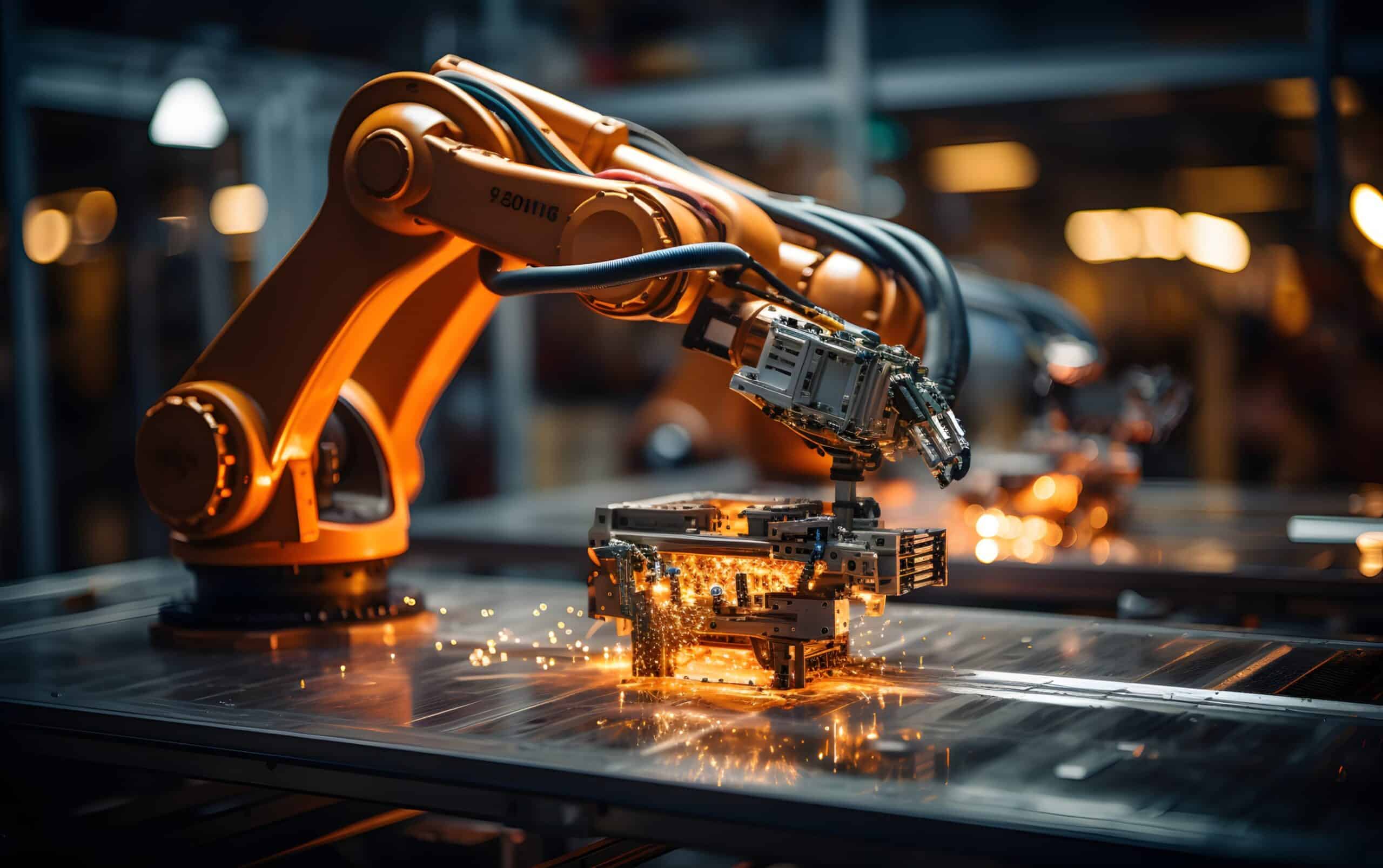

Oggi sempre più aziende produttive si dotano di sensori da apporre sulle macchine che registrano una gamma di indicatori inerenti al processo e ci richiedono di analizzare i dati rilevati ed archiviati per aiutarli a capire come le diverse variabili incidano sul prodotto finale o sui guasti dei dispositivi meccanici in modo da prendere migliori decisioni di business. Questi sono solo alcuni esempi che fanno capire le dimensioni di questo fenomeno inarrestabile; basti pensare che i dati prodotti oggi dal genere umano in un solo anno superano tutti i dati prodotti nel corso dell’intera storia della civiltà umana.

Si tratta di quella quantità enorme di dati, in massima parte grezzi, conservati così come sono stati registrati nelle rispettive sorgenti, destrutturati, comprendenti immagini, video, emoticon, ricerche, tutte informazioni che necessitano di operazioni di pulizia e normalizzazione per essere fruibili e trasmettere informazioni di valore, attività che necessitano di tempo e risorse, costituendo il primo step di analisi costi e benefici prima di procedere in tale direzione.

Raccogliere i dati

Va da sé che pertanto prima di tutto bisogna analizzare quanto c’è di prontamente disponibile, rimandando ad uno step successivo il data mining più spinto, proprio qualora le prime attività di “carotaggio” facessero affiorare l’esistenza di filoni di grande valore all’interno degli agglomerati di dati che si stanno analizzando.

Nel caso ci fosse la necessità si potrà anche procedere anche all’acquisto di banche dati esterne, tramite aziende specializzate nella vendita di informazioni relative agli acquisti e alle preferenze degli utenti settorializzati per cluster specifici; in alternativa si potrebbero indire sondaggi tra i clienti, chiedendo recensioni che producono dati solitamente strutturati e pronti per essere utilizzati, o eventualmente estrarre dati pubblici e prodotti spontaneamente sui social come Facebook, Twitter o Instagram.

Visualizzare i risultati

Alla fine di questo processo di estrapolazione dell’informazione è essenziale comunicarla in maniera efficace mediante la più opportuna visualizzazione tramite report grafici ad hoc e se possibile anche tramite uno story -telling che renda più incisiva la presentazione.

Nella creazione di un cruscotto è importante dosare il giusto equilibrio di analisi e sintesi, in quanto la semplice aggiunta del maggior numero possibile di visualizzazioni dati può generare confusione e impedirne la comprensione.

.

.

Solitamente viene realizzata una prima dashboard di apertura più generica, allo scopo di dare una visione d’insieme sull’andamento aziendale e permettere decisioni più ampie, seguita da successivi cruscotti che si concentrano su determinati aspetti del business entrando nel dettaglio con analisi drill-down.

Gli indicatori di business e performance, i kpi, sono da collocare in una posizione di evidenza, per garantirne la fruizione e la comprensione immediata all’apertura dell’applicazione; viene poi data priorità alla visualizzazione di elementi critici che possono influenzare pesantemente l’andamento aziendale. A seconda delle esigenze può poi essere gestita la creazione di gerarchie per archiviare informazioni importanti, ma non immediatamente rilevanti.

Grafici e tabelle vengono utilizzati per fornire rispettivamente informazioni di sintesi e di analisi; nella scelta dei grafici risulta fondamentale partire sempre dai dati e trovare una visualizzazione che funzioni, che ne trasferisca efficacemente il significato, e mai il contrario, ovvero forzare i dati ad una visualizzazione che piace, in quanto si rischia di fornire una rappresentazione erronea, confusa o in ogni caso poco efficace.

Naviga per categoria:

Seleziona una categoria d’interesse dal nostro magazine